ich eröffne einen neuen Faden und hoffe wieder auf interessante Beiträge.

Demoktrit forumlierte vor 2400 Jahren die atomare Struktur des Weltaufbaus, die heutzutage jedem Kind bereits nahegebracht wird. Newton formulierte etwas später seine Gravitationstheorie, die uns lehrte warum ein Ball so weit fliegt, wie wir zum Mond fliegen können etc. Einstein kondensierte diese Theorien mit neuen Ansätzen zu seinen Relativitätsprinzipien. Planck erkannte, dass Materie endlich ist in Ausdehnung und Zeitverhalten. Gravitation im Verständnis mit der Relativität eröffente völlig neue Ansätze zum Weltverständnis, obwohl oder eventuell gerade weil das verhältnis der Gravikraft zur Elektromagnetkraft zwischen 2 Protonen in der Ordnung von 1e-38 liegt. Auch erscheint es irrsinning, aber wir haben es erkannt: Gerade die geringsten Distancen verlangen die allergrößten Energieeinträge, damit sie überwunden werden können.

Folgen wir diesem letzten Satz und begeben uns auf die Reise in immer geringere Abstände oder Distancen, so wird die Energie derartig gewaltig anwachsen, dass Gravitationseffekte oder die Gravitation selber mehr und mehr in den Vordergrund treten. Wenn wir dann schlussendlichgeringseten Abstand, den Planck benannte 1.6e-35m angekommen sind, so haben wir eine derartig hohe Energie, dass wir ein Schwarzes Loch erzeugen können! Damit das aber eben nicht passiert -denn es passiert ja auch in Wirklichkeit nicht- werden wir offensichtlich gezwungen bereits vor Erreichen dieses Abstandes die Welt zu quantisieren.

Das ist die Geburtswehe der Quantengravitation.

Die theoretischen Physiker standen vor neuen nahezu unfassbaren Aufgaben.Heisenberg sah diese Problome voraus., da die Kopplung mit der Gravitations als konstanten Eintrag nicht durchgeführt werden konnte. Es stimmte einfach nicht überein. Die Newton Gravikonstante G ist umgekehrt proportional zur Energiedimension: G = abs(E^-2). Dagegen erwiesen und erweisen sich die Beiträge in einer gestörten Expansion (der bekannte englische Fachausdruck heißt hier: pertubative expansion) jedoch zeigt: G*E^2 und die Störungstheroieerwartet einen Zusammenbruch bei GE^2~1 und fürt damit auf die Planck Energie.

Die Physik erklärt dies mit ohrer nicht-renomierbaren Theorie

Die Schwierigkeit in der sich die Physik nun befand war und bleibt, dass all diese Effekte nichtlinear sind, was das Lösen der Differentialgleichungen extrem problematisch gestaltet. Nichtlineare DGLs sind bis auf ganz wenige Ausnahmen nicht geschlossen lösbar!

Das weitere Problem lautete: die Welt ist nichtdeterministisch, denn die Quantentheorie spricht nur von Wahrscheinlichkeiten, von einer statistischen Aussage. Jedoch in der Quantengravitation ist die Raumzeit -diese ist wie wir alle im Forum ja wissen über die Metrik fest mit Raum und Zeit verbunden- eine Trägheit und besitzt darüber hinaus, was sich von der Wortwahl her führend als Widerspruch erscheinen liesse eine eigenschaft eines dynamischen Geschehens. Damit mussten die Physiker ihre Theoreien neu formulieren, was nicht weiter schlimm ist, aber Aufwand bedeutet, denn die "alten" Ansätze waren ja nicht falsch mussten "nur" erweitert werden.

Die Suche nach der großen Vereinigung begann. Das Problem war, dass die Grundkräfte zwar ähnliche Gleichungsstrukturen hatten, sich aber doch unterschieden. Ganz problemtatisch war die Sache mit der elektrischen und der magnetischen Kraft. das Auffinden eines magnetischen Monopols, der gleichbedeutend ist mit der Isolation einer magnetischen Ladung, führte zu großen Mißverständnissen und zu fantastischen Lösungen: die Eichtheoretiker waren am Werk und fanden mit dieser Symmetrierung die Lösung des magnetischen Monopol als "String". Das war die Geburt der Stringtheorie. Aber diese war unbeeinflusst von den Planck Größen und kannte auch keine gravitativen Einflüsse.

Es musste ein störungsfreier Ansatz her, der diese Dynamik beinhaltet. Die Schleifenquantentheorie betrat die Bühne. Der Problemkreis war und ist die Störungstheorie, die eventuell sogar falsch ist und nicht die ganze Tiefe der Quantenrelativität im Allgemeinen wiedergibt.

All diese Ideen, uns im Forum mittlerweile wohlbekannt haben den großen Nachteil, dass ihre Gleichungen zum Teil unlösbar sind, da es genügend viele Probleme mit nichtintegrablen Raumzeittransformationen gibt. Ih erinnere hier e.g. (ex genere = aus dem Allgemeinen gegriffen) an die Greensche Funktiuon des Morse-Potentials oder an die spektrale Darstellung der Greenschen Funktion.

Aus ihr geboren oder eventuell auch als eigenständiger Ansatz zu sehen ist eine sehr interessante sehr neue Theorie entstanden:

Kausale Dynamische Triangulation.

Damit diese störungsfreie Theorie handhabbar wird, fangen wir mit einfachen Beobachtungen an, so beispielsweise der Berechenbarkeit von Gleichungen. Diese Berechenbarkeit erfordert eine endliche Anzahl an Freiheitsgraden. Das kennen wir aus dem täglichen Leben und unsere Rechner bedienen sich dieser Vorschrift. Die Mathematiker nennen dieses Numerik.

Im Falle der Quantengravitation ist die Anzahl der Freiheitsgrade aus der geometrischen Anschrift oder Konfiguration der Raumzeit zu entnehmen und ist zunächst unendlich groß. Was kann man tun?

Wir können dies ändern, indem wir sowas wie eine Abtastung durchführen. Wir Ingenieure tun das gerne: nehmen wir einen Signalstrom im zeitkontinuerkiechem Bereich und aus diesem nehmen wir in zeitlich gleich verteilten sehr zeitkurzen Abschnitten Werte (im englisch heisst das: "sample"), dann überführen wir das System von der Laplace Ebene in die z-Ebene. Das gleiche wednen wir mal bei der Raumzeit an.

Damit führen wir quasi "grobkörnige" Abschnitte der Raumzeit (diese bleibt darin konstant) ein und nennen dies:

Triangulation.

Die Verbindung der Raumzeitstückchen mit solchen triangulierten Teilstücken kennzeichnet sich im Analogon zur z-Transformation als identische Triangulationen. Solche Triangulation besitzt eine Dynamik, die jedoch voraussichtlich nicht jeden Feiheitsgrad kodieren werden wird.

Die Idee dahinter ist faszinierend, denn so kann z.B. das Feynman Pfadintegral für diskrete Positionen in der Zeit angegeben werden:

tk = k * t/N für k = 1, 2, 3, 4, ..., N

Dieser Ansatz ist in unseren Simulatoren ein Vielvwerwendeter. Jeder, der SPICE, CADENCE oder andere Simulatoren kennt, kennt den Begriff

"Piecewise-linear". Damit kann ein Integral über numerische Mehtodik geöst werden. Für ein Integral, wenn wir es denn mal hier auf unsere bedürfnisse beziehen, muss dann stets ein Fehlerbereich angegeben werden. Damit wird der Pfad dieses Integrals nicht mehr so schön geradlinig, sondern von Schritt zu Schritt ergibt sich jeweils ein Geradenstückschen, welches 2 aufeinanderfolgende und berechnete Zeitstückchen verbindet. Der Weg ist diskretisiert.

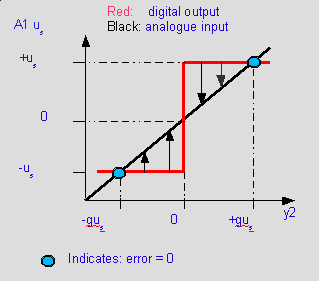

Folgen wir dieser Diskretisierung, so machen wir einen Fehler, ich zeige das mal in folgendem Bild:

Der Fehler, den wir hier machen wir durch die schwarzen Pfeile verdeutlicht. Mathematisch formulieren wir den Fehler zu:

\fedon\mixon\sigma^2 = 1/q * int((-q/2 - y),q,0,q/2)^2 + int((q/2 - y),q,-q/2,0)^2 = q^2/12

\fedoff

Danach kann der gesamte Wertebereich als digitale Information mit

E^2/sigma^2 und E = q*2^n

niedergeschrieben werden. Diese Art des Fehler heißt Quantisierfehler (nicht zu verwechseln mit Rauschen!!!).

Prinzipiell ist das schon alles. Mittels dieses Digitalisierens der Integrale können damit die kosmologischen Gleichungen in ein Rechnermodell, einen Simulator überführt werden. So beispilesweise wird aus der Ricci Skalar Kurve eine Linearisierung mittels sogenannter Delta Funktionen (Abtastbreite oder Abtastzeit wird als Delta bezeichnet ...der Dirac ist das infinitesimal kurze Abtastintervall). Die Integrale verschwinden und werden durch Summen ersetzt.

Der Einstein-Hilbert Wirkung ...siehe http://de.wikipedia.org/wiki/Einstein-H ... Wirkung--- wird somit diskretisiert und als Summe geschrieben. und nennt sich jetzt: Polyakov Wirkung, die eine Weiterführung der Regge Wirkung ist.

http://de.wikipedia.org/wiki/Polyakov-Wirkung

Mit dieser Quantisierung können auch sehr komplexe kosmologische Zusammenhänge gerechnet werden.

Was wir mit dieser Idee erhalten ist eine Folge von diskreten Werten, quasi als statische Momentaufnahme eines Zeitstückchens delta_t. Die Probleme liegen darin, dass damit Information verloren geht, was sich z.B. in den Spektren bemerkbar macht. So zeichnet sich eine abgeshlossene Sinuswelle durch das Fourierintegral mit den Integrationsgrenzen der Zeit von minus Unendlich bis plus Unendlich als idela scharfe Spitze (Peak) ab, während sich die gleiche Welle innerhalb der Integrationsgrenzen -T bis + T spektral aufweitet und auch am Rande abklingende Wellenerscheinungen zeigt. Das sind die destruktiven Interferenzen. Solche Fehler passieren bei diskretisierten Ansätzen.

Das ist der Ansatzpunkt meiner Kritik an dieser Mehtodik der kausalen dynamischen Triangulation.

Denn wenn die Wissenschaft sich "einen abbricht" möglichst präzise zu rechnen und Modelle mit kleineren Fehlern kritisiert, dann kann doch ein solcher Ansatz allenfalls einer Vergröberung, einer Vereinfachung eines bereits manifestierten Ansatzes sein und nichts anderes.

Wiederum ein Vergleich:

Berechnen wir eine Jakobi-Matrix (das ist eine mit Ableitungen), dann wird dies numerisch durch Pivotisierung einer diskretisierten, also linearisierten Funktion in jedem Simulator bzw. Digitalrechner durchgeführt. Wichtig dabei ist, dass sich der Anwender über die Fehlergenze im Klaren ist.

Wer von Euch weiß darüber mehr, wer hat diese bereits angwendet?

Gibt es inzwischen Simulatoren für kosmologische Fragen und sind die diskretisierten Fehler akzeptabel und in welcher Größenordnung liegen diese eigentlich?

Netten Gruß

Wilfried