Seite 2 von 2

Re: Verständnisfrage zur Wahrscheinlichkeit/Statistik

Verfasst: 8. Sep 2016, 13:20

von seeker

deltaxp hat geschrieben:und siehe da es war tatsächlich nur eine statistische Fluktuation, die dies jahr wieder verschwand (sehr zum Leidwesen aller Physiker...). auch bei 5 Sigma könnte es noch eine sein, aber das ist soooooooo unwahrscheinlich, dass man das es viel wahrscheinlicher ist zu sagen, das Signal ist echt, es ist ein Teilchen.

Das allein reicht eh noch nicht, auch nicht Sigma 'was weiß ich'.

Systematische und zufällige Fehler:

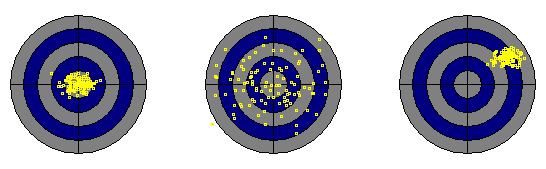

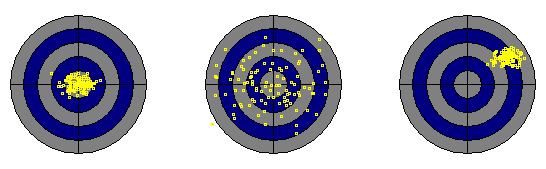

Links: Hohe Richtigkeit mit hoher Präzision. Mitte: Hohe Richtigkeit mit geringer Präzision. Rechts: Geringe Richtigkeit mit hoher Präzision. Hier tritt ganz offensichtlich ein systematischer Fehler auf.

http://www.statistics4u.info/fundstat_g ... uracy.html

Links: Hohe Richtigkeit mit hoher Präzision. Mitte: Hohe Richtigkeit mit geringer Präzision. Rechts: Geringe Richtigkeit mit hoher Präzision. Hier tritt ganz offensichtlich ein systematischer Fehler auf.

http://www.statistics4u.info/fundstat_g ... uracy.html

Schaut mal die Zielscheiben an.

Auf der linken Scheibe ist die Streuung genauso gering wie auf der rechten (identisches Sigma), dennoch ist der Messwert auf der rechten Scheibe falsch. Wenn man nicht sicher weiß, wo der wahre Wert zu liegen hat, ist es nicht einfach zu wissen ob man die linke oder die rechte Scheibe in seinen Messwerten vor sich sieht, rein statistisch kann man es gar nicht entscheiden. Und wenn gar kein wahrer Wert in dem Sinne existiert (z.B. Teilchen existiert nicht), können solche Ergebnisse auch einfach ein Artefakt sein. Das muss man ausschließen - und das geht auch nicht nur rein statistisch.

Gruß

seeker

Re: Verständnisfrage zur Wahrscheinlichkeit/Statistik

Verfasst: 8. Sep 2016, 13:47

von tomS

Deswegen werden Experimente unabhängig (unabhängige Kollaboration, unabhängiger Aufbau = anderer Detektor, unabhängige Auswertung = eigene Software, ...) überprüft.

Re: Verständnisfrage zur Wahrscheinlichkeit/Statistik

Verfasst: 8. Sep 2016, 13:50

von seeker

Genau!

Denn:

Niemand glaubt an eine Theorie, bis auf die Person, die sie gemacht hat, aber unglücklicherweise glaubt jeder an Messwerte, bis auf die Person, die sie erhoben hat.

Gruß

seeker

Re: Verständnisfrage zur Wahrscheinlichkeit/Statistik

Verfasst: 8. Sep 2016, 16:42

von deltaxp

systematische abweichungungen sind in der tat "böse". da wird, und ich sprech da aus eigener Erfahrung meiner doktorarbeitszeit, sehr sehr viel zeit darauf verwendet, die zu erfassen. man ist dort sehr konservativ.

ganz so blind ist man bei hochenergie-Experimenten nicht. man hat eine 0 Hypothese, die ist ein bestehednes theoriemodell und ein bestehndes detektor-Modell. dann wird zuerst in bereichen, wo man sicher ist das das theorie-Modell stimmt kräftig montecalosimulationen von Streuungen in der detektor-akzeptanz gemacht. das wird dann verglichen mit den tatsächlichen messergebnissen, und erst wenn das zusammenpasst nach ewigen kalibrationssphasen wird in Bereiche gegangen von man sich neue Sachen erhofft. zusätzlich werden systematische fehler aus Modellen (da gehen ja Messwerte auch wieder mit ein) mit abgeschätzt.

aus der Theorie her ist am cern das std-modell die Basis. damit wird gerechnet, was man in den verschiedenen Energiebereichen zu erwarten hat, das ist der Untergrund, die mitte der Zielscheibe, und von diesem muessen sich messungen statistisch signifikant unterscheiden, für ein Teilchen, das ist dann immer ein buckel über dem Untergrund, da der streuquerschnitt bei cms-energien die der invarianten masse des hypothetischen Teilchens entsprechen grösser als der des Standardmodell ist (das macht man schon seit den 50ger jahren oder so so).

und dieser abstand muss mehr als 5 Sigma zum Untergrund sein. es reicht also nicht 1 Ereignis sondern man braucht sehr viele um den statischen fehler klein zu kriegem, da der im wesentlichen immer (physikalische grösse) / sqrt(N) geht.

wenn sowas auftritt wird nochmal davon ausgegangen, dass der Effekt ein systematischer messfehler oder analysefehler ist und übelst rumgesucht ob man nicht doch was übersehen hat. deswegen werden die Daten von unabhängigen gruppen mit anderer analyse-Software untersucht. und es werden ohnehin andere Experimente mit ganz anderer hard und Software die auf ganz anderen wegen die interesssierende physikalische grösse ausganz anderen messungen ableiten. und erst wenn die das ebenfalls nach den Fehlersuchen auch sehen, dann traut man sich zu sagen, okay. da ist wirklich was und veröffentlicht.

das ist ein sehr mühseliger Prozess. 99% ist man als datenauswertender experimentalphysiker dort letzlich mit Fehlerrechnung und Fehlersuche beschäftigt.

Re: Verständnisfrage zur Wahrscheinlichkeit/Statistik

Verfasst: 8. Sep 2016, 22:47

von Pippen

deltaxp hat geschrieben:in der teilchenühysik fordert man wie gesagt 5sigma abstand zum Untergrund bis ein Teilchen als entdeckt gilt.

Verstehe ich dich richtig? Ich könnte also bei meiner Münzwurfreihe zB 2Sigma-Abstand festlegen und dann sagen: meine kkkkk wären außerhalb von 2Sigma und daher gilt die betreffende Wahrscheinlichkeitsverteilung nicht. Richtig?

Re: Verständnisfrage zur Wahrscheinlichkeit/Statistik

Verfasst: 9. Sep 2016, 11:08

von deltaxp

2 Sigma is a bisserl wenig, aber im Prinzip ja. wobei die Interpretation so ist:

Du stellst eine Nullhypothese auf. die lautet typischerweise, dass dein Messergebnis, dass du aus N Beobachtungen gewonnen hast, auch durch reinen Zufall auf Basis einer bestimmten Verteilungsfunktion - typischerweise Normalverteilung - um den Erwartungswert deiner Nullhypothese auch erzeugt worden sein kann mit einer bestimmten Wahrscheinlichkeit. Bei einer Gaußverteilung sind 2 Sigma Abstand zum Erwartungswert deiner Nullhypothese immer noch etwa 5% glaube ich. Wenn die Zufallswahrscheinlichkeit der Nullhypothese kleiner ist als die von DIR vorgegebene schwelle verwirfst du die Nullhypothese, aber man kann damit nicht eine Alternativhypothese beweisen, sondern nur zunehmend das Vertrauen in sie steigern, wenn Messungen ein ums andere mal von ihr (im rahmen der statistischen Genauigkeit) richtig vorhergesagt wurden.

Die Nullhypothese am CERN ist das Standardmodell. Damit wird der Streuquerschnitt für bestimmte Energien berechnet. Damit hast du dein Nullhypothesen-Erwartungswert. Um diesen streuen die zufallsgenerierten Ereignisse dann mit 1/sqrt(N) in erster Näherung mit einer Gaußverteilung. Damit kennst du die Wahrscheinlichkeit bzw. der Sigma-Abstand eines möglichen Ausreissers durch Zufall. Wenn du jetzt mehr als 5 Sigma bei eine neuen Teilchenentdeckung weg wärest, würdest du die Nullhypothese verwerfen, weil die Wahrscheinlichkeit das beim Standardmodell durch eine statistische Fluktuation so ein Ausreisser bei N Ereignissen vorkommt dafür kleiner als 0.0000001% (oder so ist, muss man mal nachschlagen was 5 Sigma bei ner gausverteilung sind) ist. aber damit weisst du nur dass da was neues ist. aber du kansnt noch nicht sagen. yo das ist die stringtheorie oder die spaghetti-monster Theorie als Alternative.

Alternative Theorien muss man dann nach ähnlichem Prinzip (da setzt du die dann als Nullhyothese ein) verwerfen. Aber man kann sie nie bestätigen, nur vertrauen steigern, wie ich oben erwähnte.

Ist wie gesagt, alles a bisserl gewöhnungsbedürftig. und keiner mag das wirklich. ich bin ja nun in der medizintechnik tätig und lese da viele Veröffentlichungen von medizinischen Studien. Die Mediziner nehmen da immer fertige Tools, die hauen dann den den p-wert raus (Zufallswahrscheinlichkeit) und gut ist. Ich bezweifle dass die Leute alle wissen was sie da tun, und manchmal schlag ich mir auch die Hände vors Gesicht, weil sie da echt versuchen ne Hypothese zu bestätigen. Man kann aber maximal sagen. Das Ergebnis widerspricht nicht der Hypothese, man kann sie daher nicht ausschliessen, mehr aber nicht. naja, aber ich kann denen da irgendwie auch keinen vorwurf machen, Statistik ist i.a. nicht intuitiv und wenn man nicht täglich damit zu tun hat auch schwer in den Kopf reinzuprügeln. Da ist unser Gehirn nicht für gemacht.